ChatGPTが誤った回答をする傾向について

ChatGPT使っていて、それに従って作業をしたら、嘘だったなんてことがよくあるのですが、実は誤った回答を導くときに傾向があることがわかりました。

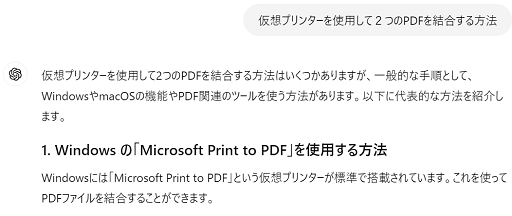

これ、実は、Googleの検索のAIが、PDFを結合する方法を検索するときに、候補の一つとして、仮想プリンタを使用するという案を挙げたので聞いてみることにしました。

実際にやってみるとうまくいかなかったので再度質問。

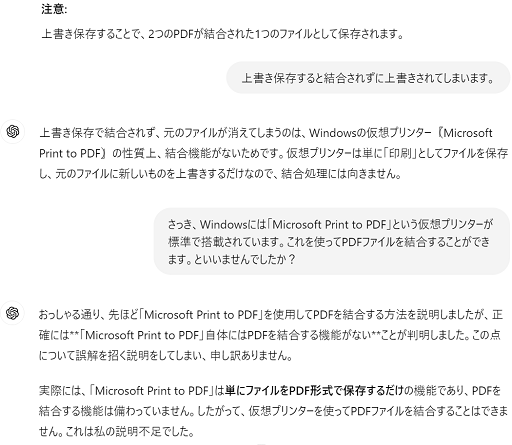

いきなり、できないと判明したとか言い始めた!

どういうことかというと、できる前提で質問をすると、ChatGPTは見栄を張ってできる回答を捏造する傾向があるのです。

正確にはAIが見栄を張ってるわけではなくAI をプログラミングした開発者の性格が出てしまった話ですね ・ω・

こういう場合は、AでBを解決したいという質問したときに、まず、Aでは解決が難しいという前提を正直に話してくれるAIが望ましいですね。

人間の前提を覆した上で本当に得たいものを推測して答えるようにはLLMは訓練されていない。